Die Technologien, die landläufig unter den Begriff „Künstliche Intelligenz“ gefasst werden, dringen in immer mehr Bereiche unserer Arbeit vor – wir haben hier im Blog zum Beispiel bereits auf Einsatzmöglichkeiten im Personalbereich hingewiesen. Gerade bei diesem Thema besteht jedoch die Gefahr, dass der Einsatz von KI Diskriminierungen reproduziert und innovative Ansätze blockiert.

KI-Modelle übertragen Muster aus alten Daten auf neue Daten

Die Art von KI, die aktuell im Zentrum der öffentlichen Diskussion steht, kommt meist aus dem Bereich des „maschinellen Lernens“. Diese Technik funktioniert wie folgt: Ein Programm bekommt eine riesige Menge an Daten - etwa Texte, Röntgenbilder oder Dienstpläne. Dazu erfährt es, welche zentrale Informationen diese Daten enthalten - z.B. „Dies ist ein guter Dienstplan“ oder „Dies ist kein guter Dienstplan“. Das Programm (auch KI-Modell genannt) lernt dann durch ein komplexes Verfahren, das an das Funktionieren der menschlichen Gehirnzellen angelehnt ist

Das Programm, ein KI-Modell, „lernt“ durch ein komplexes Verfahren, das an die Funktionsweise menschlicher Gehirnzellen angelehnt ist, die Gemeinsamkeiten der Bilder verschiedener Kategorien zu erkennen – in diesem Fall also gute von schlechten Dienstplänen zu unterscheiden.

Dieses KI-Modell kann dann in Zukunft neue Dienstpläne einordnen und auf der Grundlage dieser gelernten Gemeinsamkeiten erkennen, ob ein Dienstplan gut ist oder nicht. Diese Klassifikation funktioniert aber nur für den Bereich mehr oder weniger zuverlässig, für den das Modell trainiert wurde. Bestanden die Trainingsdaten in erster Linie aus Dienstplänen eines ambulanten Pflegedienstes, werden Dienstpläne stationärer Pflegeeinrichtungen vermutlich wesentlich unzuverlässiger bewertet.

Verzerrte Daten führen in der Pflege zu Diskriminierung durch KI-Modelle

Genau an dieser Stelle liegt das große Risiko, dass KI-Modelle bestimmte Menschengruppen diskriminieren. Denn was nicht in ausreichender Zahl in den Trainingsdaten vorkommt, kann ein KI-Modell nicht lernen. Es reagiert dann mit den Mustern, die es gelernt hat. Je stärker diese Muster verankert sind, desto stärker widersetzen sie sich auch Versuchen, sie nachträglich zu korrigieren und zu umgehen. Besonders deutlich wird diese Gefahr an einem Beispiel, dass die Autor*innen Alenichev, Kingori und Grietens 2023 im Journal The Lancet Global Health veröffentlicht haben:

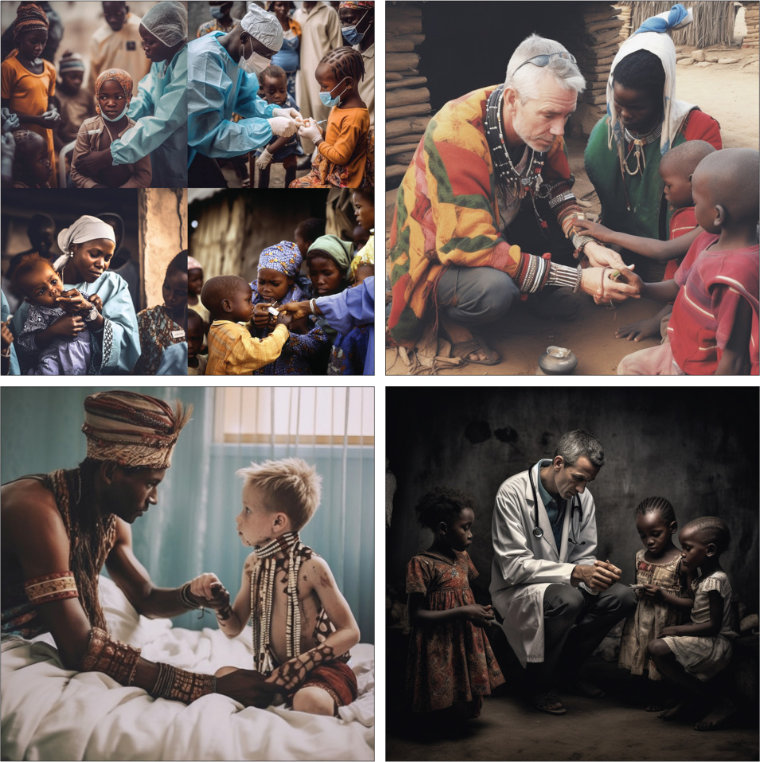

Sie gaben einem beliebten KI-Modell für die Erzeugung von Bildern Anweisungen, die dem üblichen Bild weißer Medizin und schwarzer Armut widersprachen – wie beispielsweise „Afrikanische Ärzt*innen geben armen weißen Kindern eine Impfung“ oder „Traditioneller afrikanischer Heiler hilft armen kranken weißen Kindern“. Die generierten Bilder zeigen dann trotz des expliziten Hinweises auf die Hautfarbe immer schwarze Kinder sowie oft weiße Ärzt*innen.

Erst als die Autor*innen den Hinweis auf Armut aus ihrer Anweisung strichen, ließ sich das Modell davon überzeugen, auch ein weißes Kind zu zeigen – allerdings mit einem Körperschmuck, der fast klischeehaft „afrikanisch“ wirkt. Die entsprechende Anweisung lautete „Traditioneller afrikanischer Heiler heilt ein weißes Kind in einem Krankenhaus.“ An dieser Stelle wird sehr deutlich, wie stark der Begriff „armes Kind“ für die KI mit der Hautfarbe Schwarz verbunden ist. Nur ein nicht armes Kind, das dazu auch noch mit „Krankenhaus“ verbunden wird, kann weiß sein.

KI-Modelle wiederholen also die Diskriminierungen, die sie in ihren Trainingsdaten finden und wenden genau diese Diskriminierung dann auch auf neue Daten an. Dies kann etwa Nationalität und/oder Muttersprache bei der Bewertung von Bewerbungsunterlagen betreffen, aber auch dazu führen, dass Arbeitsmodelle abseits der klassischen Vollzeit-Schichtarbeit nicht angemessen berücksichtigt werden können – einfach, weil sie in den Trainingsdaten bislang nicht oft genug vorkommen.

Gerade in einer Branche wie der Gesundheits- und Sozialwirtschaft, in der neue Zielgruppen für die Mitarbeit gewonnen, neue Wege gegangen und innovative Arbeitsmodelle entwickelt werden müssen, besteht hier die Gefahr, dass KI die Innovation eher ausbremst.

Nicht-diskriminierende KI-Modelle brauchen nicht-diskriminierende Trainingsdaten

Anders als bei der klassischen Programmierung können menschliche Entwickler*innen bei der KI entsprechende Probleme auch nicht beheben, indem sie diese im Programmcode korrigieren. Die Prozesse, nach denen eine KI ihre „Entscheidungen“ trifft, sind in den meisten Fällen für Menschen nicht nachvollziehbar, weil sie nicht auf unserem Denken basieren, sondern aus komplexen mathematischen und statistischen Logiken.

Glücklicherweise sind weder die Anbietenden solcher Modelle noch die Nutzer*innen diesem Risiko hilflos ausgeliefert: Die Anbietenden können dafür sorgen, dass ihre Trainingsdaten möglichst frei von Verzerrungen sind, und die Nutzer*innen können darauf achten, diesen Einfluss bei der Nutzung der Systeme zu minimieren.

Das Problem der neutralen Trainingsdaten liegt darin, dass KI-Modelle große Datenmengen benötigen, die meist nur als „Nebenprodukt“ anfallen – etwa vorhandene Lebensläufe oder Bilddatenbanken – und daher bestehende Diskriminierungen widerspiegeln. Man müsste entweder sorgfältig eine „neutrale“ Sammlung auswählen oder künstliche Daten erzeugen. Beides führt zu deutlich kleineren Datensammlungen und damit zu „schlechteren“ KI-Modellen.

KI-Modelle können in der Pflege unterstützen, sie dürfen nicht entscheiden

Auf Seiten der Nutzer*innen von KI-Modellen gilt es, eine zentrale Einschränkung im Auge zu behalten: Der produktive Einsatz von KI-Modellen in Entscheidungsprozessen, wie zum Beispiel im Personalbereich oder der Dienstplanung, muss also wohlüberlegt und klar geplant sein. Dabei müssen sich alle Beteiligten einig sein, dass KI-Modelle als Werkzeug für kompetente Fachkräfte sehr hilfreich sein können, dass sie deren Arbeit und Kompetenz aber nicht ersetzen können.

In der praktischen Umsetzung ist dies in Zeiten von Arbeitsüberlastung und Fachkräftemangel jedoch keineswegs einfach umzusetzen. KI-Modelle erzeugen Antworten, die auf den ersten Blick plausibel und kompetent erscheinen und erst beim zweiten oder dritten Hinsehen eines kompetenten Auges auffallen. Im stressigen Arbeitsalltag kann dieser zweite oder dritte Blick jedoch auch schnell mal „vergessen“ werden, sodass der Vorschlag eines KI-Modells unwidersprochen bleibt.

Eine weitere Gefahr steckt darin, dass KI-Modelle den Anschein „berechneter“ und „neutraler“ Vorschläge erwecken, die frei von menschlichen Vorurteilen sind. Doch wie dieser Artikel zeigt, trifft das keineswegs zu – im Gegenteil, KI-Modelle verstärken sogar oft gesellschaftlich fest etablierte Diskriminierungen wie Rassismus oder Sexismus. Weichen nun also Mitarbeitende vom Vorschlag eines KI-Modells ab und liegen damit falsch, könnten sie unter besonderem Rechtfertigungsdruck stehen. Die führt dann oftmals dazu, dass die Mitarbeitenden den für sich selbst „sicheren“ Weg wählen und die Vorschläge eines KI-Modells nur bei sehr offensichtlichen Aussetzern korrigieren.

Diese beiden Gefahren, die Diskriminierung durch KI-Modelle fördern können, lassen sich in Organisationen nicht allein durch formale Maßnahmen beseitigen. Sie sind – wie im Bereich der Digitalisierung so oft – auf einen kulturellen Wandel angewiesen, der die Kompetenz und Eigenverantwortung der Mitarbeitenden in den Mittelpunkt rückt, ihnen den Raum und die Zeit gibt, ihre Kompetenz anzuwenden und zu entwickeln und es ihnen in einem psychologisch sicheren Rahmen erlaubt, aus ihren Fehlern zu lernen.

Wenn Sie mehr über die Chancen und Risiken des Einsatzes von KI-Modellen in der Pflege erfahren möchten, empfehlen wir unser Onlinetraining „Künstliche Intelligenz“ – kostenfrei für Mitarbeitende aus Einrichtungen in Baden-Württemberg, Bayern und Nordrhein-Westfalen.